- Il est étonnant de voir à quelle vitesse les processeurs les plus rapides exécutent les instructions, alors pourquoi n'utilisons-nous pas toujours ce qu'il y a de plus rapide ?

- Nous dressons la liste des raisons pour lesquelles l'utilisation de la technologie la meilleure et la plus avancée est rarement judicieuse.

- Certaines raisons, tu les connais déjà (les données financières), mais d'autres t'ont peut-être échappé.

Imagine : ton réfrigérateur, ta montre et même ton grille-pain fonctionnent tous avec le processeur le plus rapide jamais conçu.

Ça a l'air incroyable, non ? Comme quelque chose tout droit sorti d'un film de science-fiction. Mais lorsque j'ai commencé à creuser sur les raisons pour lesquelles nous ne En fait, je me suis rendu compte que c'était beaucoup plus compliqué (et intéressant !) que de dire simplement "plus c'est rapide, mieux c'est".

SOMMAIRE

- Comprendre les performances du processeur (CPU)

- La tyrannie de la physique : chaleur et puissance

- L'autonomie de la batterie est ce qui compte le plus lorsqu'il s'agit d'appareils portables.

- Rendements décroissants : le coût de chaque mégahertz ajouté

- Contraintes liées au facteur de forme : taille, poids et matériaux

- Processeurs spécialisés ou généraux

- Réalités des logiciels et de la charge de travail

- La fiabilité et la longévité augmentent si tu ne pousses pas les puces trop loin.

- Considérations réglementaires et environnementales

- L'impératif de l'expérience utilisateur

- Les processeurs suffisamment rapides sont souvent préférés aux processeurs "les plus rapides".

- En résumé

Comprendre les performances du processeur (CPU)

À la base, le travail d'un processeur consiste à exécuter les instructions le plus efficacement possible. En théorie, un processeur plus rapide avec une vitesse d'horloge plus élevée et plus de cœurs semble être le composant idéal pour alimenter tous nos appareils. Cependant, la vitesse brute n'est qu'une pièce du puzzle. Les performances ne se mesurent pas seulement en fonction du nombre d'opérations par seconde qui peuvent être effectuées, mais aussi en fonction de l'efficacité avec laquelle ces opérations sont réalisées dans des conditions réelles.

Par exemple, un processeur conçu pour les ordinateurs de bureau haut de gamme peut exceller dans le multitâche lourd et les applications intensives. Mais si tu l'introduis dans un appareil mobile, tu risques de rencontrer des problèmes qui l'emportent sur les avantages qu'il offre en termes de performances.

L'écart entre les vitesses maximales théoriques et les performances pragmatiques et durables est comblé par des facteurs tels que l'efficacité énergétique, la production de chaleur et les exigences de la charge de travail. Cette approche nuancée de la conception explique pourquoi les processeurs les plus rapides ne sont pas une solution universelle. Et ce n'est pas grave.

La tyrannie de la physique : chaleur et puissance

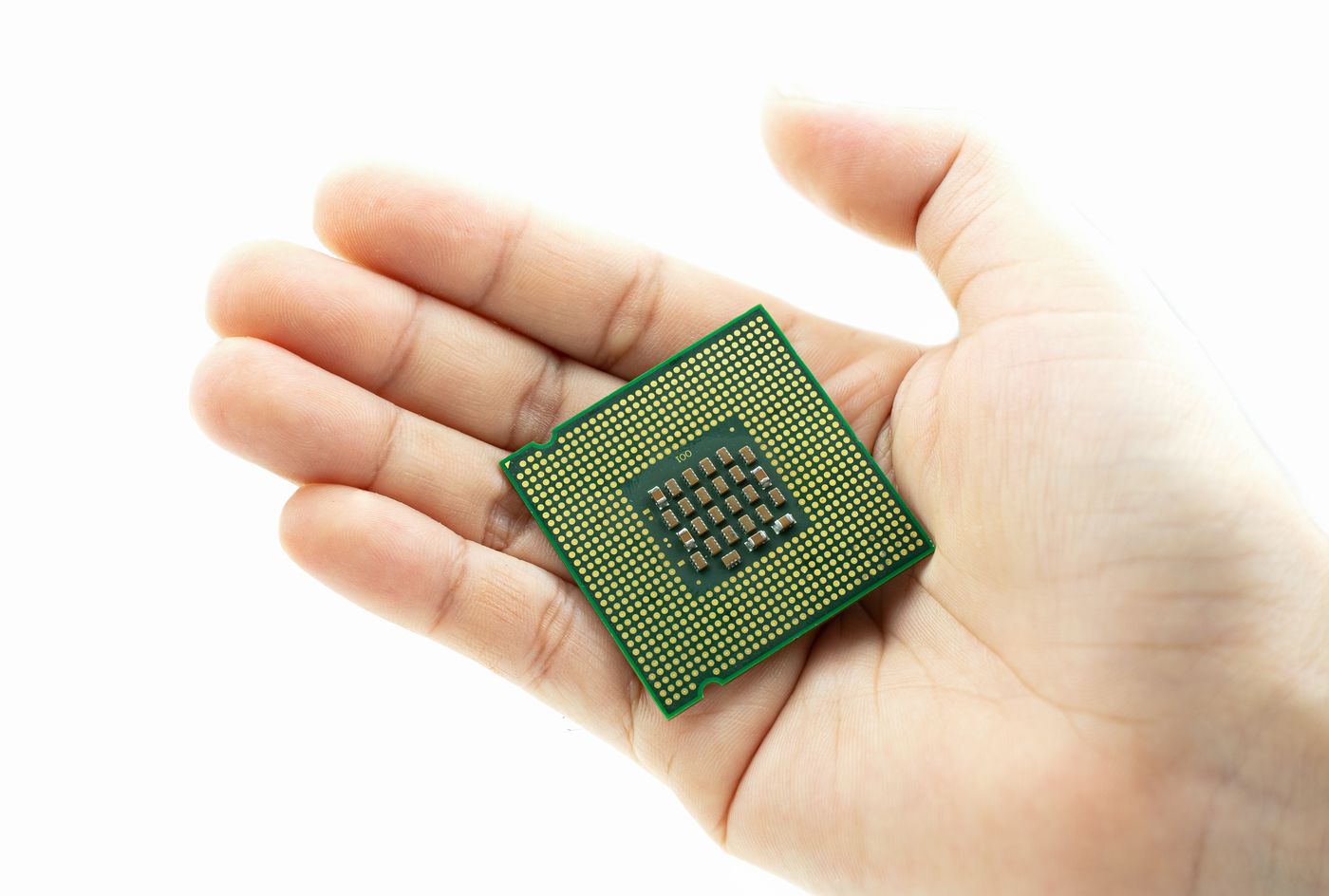

Au cœur de la physique des semi-conducteurs se trouve un compromis fondamental : vitesse d'horloge vs. dissipation thermique. Chaque fois qu'un transistor commute, il consomme de l'énergie et génère de la chaleur. Augmente la fréquence de l'horloge et la puissance nécessaire croît à peu près au carré de cette fréquence.

Dans une tour de bureau avec de la place pour des dissipateurs thermiques géants et plusieurs ventilateurs, tu peux gérer des dizaines, voire des centaines de watts de puissance thermique.

Mais essaie de mettre ce genre de budget thermique dans une coque de smartphone de quelques millimètres d'épaisseur, et tu finiras par tenir une véritable brique brûlante. Pire encore, la chaleur excessive ne rend pas seulement les appareils inconfortables au toucher, mais elle accélère également l'usure du silicium lui-même, réduisant ainsi sa durée de vie opérationnelle.

La plupart du temps, les concepteurs de produits et de puces doivent choisir des processeurs dont la puissance thermique de calcul (TDP) s'inscrit dans des enveloppes thermiques étroites, en équilibrant les performances avec une dissipation thermique fiable.

Trop de chaleur nuit non seulement aux performances, mais peut également réduire la durée de vie d'un composant et compromettre la sécurité de l'utilisateur. Par conséquent, les concepteurs optent souvent pour des processeurs qui offrent des performances "suffisamment bonnes" sans générer de chaleur excessive.

Cela signifie que, bien que les processeurs les plus rapides puissent exister dans les laboratoires (lisez ceci comme des concours d'overclocking), ils ne sont pas toujours les mieux adaptés aux appareils où l'espace est limité et où la gestion thermique est un défi critique. Il s'agit ici de trouver un équilibre, d'optimiser les performances tout en veillant à ce que l'appareil reste froid, sûr et confortable à utiliser.

Les fabricants ont développé des architectures spéciales, comme La configuration big.LITTLEE d'ARMLe système de gestion de l'énergie est un système à deux noyaux, où les noyaux à haute puissance sont associés à des noyaux à faible consommation d'énergie. Le système passe intelligemment d'un noyau à l'autre en fonction des demandes de calcul, ce qui permet d'obtenir un équilibre entre des performances élevées lorsque c'est nécessaire et la préservation de l'autonomie de la batterie lorsque les tâches sont moins intensives. Ce type de gestion dynamique de l'énergie est la clé de l'informatique mobile moderne.

L'autonomie de la batterie est ce qui compte le plus lorsqu'il s'agit d'appareils portables.

L'autonomie de la batterie est directement liée aux contraintes thermiques. Les utilisateurs modernes attendent des smartphones qu'ils durent toute la journée avec une seule charge, des ordinateurs portables qu'ils tiennent huit heures ou plus, et des wearables qu'ils fonctionnent pendant des jours ou des semaines.

Les processeurs à grande vitesse consomment beaucoup d'énergie, souvent des centaines de watts lorsqu'ils tournent près de leur horloge maximale. En revanche, un SoC mobile bien conçu prévoit généralement moins de 5 W en cas d'utilisation intensive pour tenir la promesse de fonctionner toute la journée, et ne consomme souvent que quelques millivolts dans le cadre de scénarios d'utilisation typiques et moins éprouvants.

Sans ces compromis, ton téléphone mourrait en une heure ou aurait besoin d'une batterie deux fois plus épaisse et plus lourde que la batterie actuelle. Ce n'est pas un compromis gagnant. Concevoir des processeurs à la fois puissants et efficaces n'est pas une mince affaire.

Rendements décroissants : le coût de chaque mégahertz ajouté

Imagine que tu te trouves chez un concessionnaire automobile et que les prix grimpent en flèche lorsque tu augmentes la vitesse de pointe de 1 mph. L'analogie est valable pour le silicium : faire passer la vitesse d'horloge de 4,0 GHz à 4,5 GHz peut ne coûter qu'un petit changement dans la fabrication, mais passer de 5,0 GHz à 5,5 GHz nécessite souvent des changements importants dans la conception, du silicium de qualité supérieure (binning pour les puces qui peuvent supporter plus de tension et de chaleur), et des tests plus rigoureux.

Chaque mégahertz supplémentaire au-delà d'un certain point produit des accélérations plus faibles dans le monde réel, en particulier dans les applications qui ne peuvent pas utiliser pleinement les performances brutes d'un seul thread. Pendant ce temps, les risques d'ingénierie supplémentaires, les taux de défauts plus élevés et les coûts de fabrication plus importants réduisent à la fois les marges des fabricants et les prix pour les utilisateurs finaux.

Nous voulons tous l'unité centrale la plus rapide *que nous pouvons nous permettre. Et cet astérisque fait une grande différence.

Contraintes liées au facteur de forme : taille, poids et matériaux

Au-delà du silicium lui-même, le châssis de ton appareil, les matériaux des dissipateurs de chaleur et les solutions de refroidissement imposent des limites. Un smartphone utilise de minces répartiteurs de chaleur en cuivre et s'appuie en partie sur le cadre métallique et le dos en verre pour diffuser la chaleur. Un ordinateur portable de jeu peut inclure des chambres à vapeur et des ventilateurs, mais ne peut toujours pas égaler la capacité de refroidissement d'un boîtier optimisé pour le flux d'air d'un ordinateur de bureau.

Les wearables et les gadgets IoT rétrécissent encore plus l'enveloppe : il n'y a souvent pas de place pour un refroidissement actif du tout. Les concepteurs doivent faire des compromis entre la puissance de calcul brute et les réalités physiques de la forme, du poids et des matériaux de construction de l'appareil.

Le plus souvent, la taille et le poids d'un appareil déterminent les unités centrales que tu peux utiliser. Et utiliser quelque chose de plus costaud n'est pas courageux, mais plus souvent une mauvaise décision de conception.

Processeurs spécialisés ou généraux

Dans de nombreux domaines, la pointe de la "vitesse" provient de la spécialisation. Les GPU, par exemple, dédient des centaines ou des milliers de petits cœurs, ainsi que de larges unités SIMD et une mémoire à large bande passante, à des tâches telles que le rendu graphique ou le calcul scientifique. Les TPU de Google et d'autres accélérateurs d'IA ajoutent des moteurs de multiplication matricielle pour accélérer les charges de travail d'apprentissage en profondeur.

Mais ces architectures sont optimisées pour des tâches étroites et très spécifiques, elles excellent dans les calculs parallèles en virgule flottante mais ne sont pas aussi flexibles pour l'informatique générale.

Intégrer un silicium aussi spécialisé dans chaque appareil serait exagéré (et inutile) pour les tâches quotidiennes telles que la navigation sur le web ou le courrier électronique. Au lieu de cela, les appareils utilisent des processeurs "juste ce qu'il faut" qui équilibrent les capacités générales avec des accélérateurs spécifiques à une tâche (par exemple, le décodage vidéo, l'inférence de l'IA) pour augmenter l'efficacité là où c'est important.

Réalités des logiciels et de la charge de travail

La vitesse d'horloge brute n'est qu'une partie de l'histoire des performances. Les processeurs modernes s'appuient fortement sur les hiérarchies de cache, la prédiction de branchement, l'exécution hors ordre et le multithreading pour alimenter les pipelines en données.

Dans de nombreuses applications réelles, en particulier celles qui comportent de nombreux changements de pointeurs, des accès irréguliers à la mémoire ou des entrées/sorties importantes, des fréquences d'horloge plus élevées n'apportent que des gains modestes.

Les développeurs et les architectes de systèmes constatent souvent que l'optimisation des logiciels pour la localité des données, le parallélisme et l'efficacité algorithmique donne de bien meilleurs résultats que la recherche de quelques centaines de mégahertz supplémentaires de vitesse matérielle. En effet, de nombreux appareils plafonnent les performances de l'unité centrale là où la "courbe logicielle" commence à s'aplatir, choisissant plutôt d'affiner les compilateurs, les bibliothèques et les systèmes d'exécution.

Alors oui, la façon dont tu définis "le plus rapide" a aussi son importance, car selon la charge de travail, tu peux considérer des choses complètement différentes.

La fiabilité et la longévité augmentent si tu ne pousses pas les puces trop loin.

Les serveurs et les systèmes critiques utilisent parfois des processeurs qui fonctionnent à des horloges légèrement inférieures à leur poubelle maximale, précisément pour améliorer la fiabilité. Faire fonctionner les puces à des points de tension/fréquence réduits (une technique appelée undervolting/underclocking) peut réduire de manière significative les courants de fuite et le stress thermique, ce qui prolonge la durée de vie des composants et réduit la probabilité d'une corruption silencieuse des données ou de pannes soudaines.

Les entreprises d'électronique grand public se soucient beaucoup des taux de retour, des coûts de garantie et de la réputation de la marque. Il est souvent préférable de garantir que chaque appareil survivra aux abus typiques des utilisateurs, aux sessions de jeu prolongées, aux températures ambiantes chaudes, à l'exposition à la poussière, plutôt que de pousser chaque puce à sa limite absolue.

Considérations réglementaires et environnementales

Alors que le public se préoccupe de plus en plus de la consommation d'énergie et des déchets électroniques, les organismes de réglementation et les consortiums industriels font de plus en plus pression pour que les appareils électroniques soient plus écologiques. Les organismes de normalisation comme Energy Star fixent des critères d'efficacité énergétique pour les appareils, ce qui incite les fabricants à réduire la consommation d'énergie en mode veille et en charge. Les objectifs de développement durable des entreprises encouragent en outre les conceptions qui minimisent l'empreinte carbone au cours du cycle de vie de l'appareil.

Dans ce contexte, l'utilisation du processeur le plus rapide possible dans chaque appareil, que cette performance soit réellement nécessaire ou non, va à l'encontre d'objectifs environnementaux plus larges. Un silicium de meilleure qualité et plus efficace, une gestion adaptative de l'énergie et une durée de vie plus longue des appareils sont autant d'éléments qui ont la priorité sur la vitesse d'horloge maximale.

L'impératif de l'expérience utilisateur

En fin de compte, la plupart des consommateurs se soucient moins de la vitesse d'horloge brute du processeur que de la réactivité, de l'autonomie de la batterie, de la chaleur, du bruit et de la sensation générale. Un téléphone qui est légèrement plus lent dans les scores de référence mais qui reste froid et dure 16 heures d'utilisation intensive semblera beaucoup plus haut de gamme qu'un téléphone qui passe les tests à toute vitesse mais qui s'éteint au bout de deux heures ou qui devient un radiateur de poche inconfortablement chaud.

Les fabricants consacrent d'innombrables heures aux tests UX, équilibrant la vitesse du CPU, les performances du GPU et les optimisations au niveau du système pour offrir une expérience toujours fluide dans des conditions réelles.

Cela signifie souvent qu'il faut réduire la fréquence d'horloge maximale du processeur pour atteindre un point idéal où les performances sont rapides, où la température reste stable et où l'autonomie de la batterie dépasse les attentes.

Les processeurs suffisamment rapides sont souvent préférés aux processeurs "les plus rapides".

La bonne nouvelle, c'est que "assez rapide" aujourd'hui est souvent "très rapide" demain. Les concepteurs de puces se tournent de plus en plus vers l'architecture hétérogène, combinant de gros cœurs gourmands en énergie avec des cœurs plus petits et efficaces, ainsi que des moteurs dédiés à l'IA, au graphisme et à la vidéo, afin d'associer le bon matériel à la bonne tâche.

Cela permet aux appareils d'augmenter leurs performances lorsque c'est nécessaire et de fonctionner à très faible consommation lorsqu'ils sont inactifs. Le matériel adaptatif qui se reconfigure dynamiquement à la volée, la photonique du silicium pour les interconnexions et les puces empilées en 3D promettent une flexibilité encore plus grande.

Plutôt qu'un processeur monolithique "le plus rapide", les appareils de demain pourraient rassembler une pléthore de moteurs spécialisés, chacun excellant dans son créneau, offrant des performances globales supérieures à celles de n'importe quel "gros cœur".

Tu veux savoir ce que signifie pour toi la plus grande rapidité ? Lis nos articles sur combien de cœurs de processeur as-tu besoin pour jouer aujourd'hui ? et pour exécuter des applications gourmandes en énergie.

En résumé

Alors, pourquoi ne pas équiper tous les appareils des processeurs les plus rapides possibles ? Parce que "le plus rapide" signifie souvent plus chaud, plus gourmand en énergie, plus coûteux, plus court et moins respectueux de l'environnement, des caractéristiques qui vont à l'encontre des besoins réels de l'électronique mobile, embarquée et grand public.

Au lieu de cela, l'industrie s'efforce de trouver un équilibre : faire correspondre les capacités du silicium aux cas d'utilisation, optimiser les logiciels et innover en matière d'emballage et de gestion de l'énergie afin d'offrir la meilleure expérience globale.

En fin de compte, l'objectif n'est pas une course inutile aux mégahertz, mais la création d'appareils qui ravissent les utilisateurs grâce à des performances fluides, une longue durée de vie de la batterie, des températures confortables et des prix abordables. Et c'est pourquoi les processeurs les plus "gros" et les plus "rapides" sont glorieux dans les superordinateurs et les ordinateurs de bureau phares, mais inutiles (et indésirables) dans ta vie de tous les jours.