- Es ist erstaunlich, wie schnell die schnellsten Prozessoren Befehle ausführen. Warum benutzen wir also nicht immer das schnellste Ding?

- Wir listen die Gründe auf, warum es selten sinnvoll ist, die beste und fortschrittlichste Technologie einzusetzen.

- Einige Gründe kennst du bereits (Finanzen), aber andere hast du vielleicht übersehen.

Stell dir das vor: Dein Kühlschrank, deine Uhr, sogar dein Toaster - sie alle laufen auf dem absolut schnellsten Prozessor, der je gebaut wurde.

Klingt erstaunlich, oder? Wie etwas, das direkt aus einem Science-Fiction-Film stammt. Aber als ich anfing zu erforschen, warum wir nicht Ich habe gemerkt, dass es viel komplizierter (und interessanter!) ist als nur "schneller ist besser".

INHALT

- Die Leistung des Prozessors (CPU) verstehen

- Die Tyrannei der Physik: Wärme und Strom

- Die Akkulaufzeit ist das Wichtigste bei tragbaren Geräten

- Abnehmende Erträge: Die Kosten für jedes zusätzliche Megahertz

- Beschränkungen des Formfaktors: Größe, Gewicht und Materialien

- Spezialisierte vs. Allzweck-Prozessoren

- Software und Arbeitsbelastung

- Zuverlässigkeit und Langlebigkeit erhöhen sich, wenn du die Chips nicht zu sehr strapazierst

- Regulatorische und ökologische Überlegungen

- Die Notwendigkeit der Nutzererfahrung

- Ausreichend schnelle CPUs werden oft den "schnellsten" Prozessoren vorgezogen

- Zusammenfassend lässt sich sagen

Die Leistung des Prozessors (CPU) verstehen

Im Kern besteht die Aufgabe eines Prozessors darin, Anweisungen so effizient wie möglich auszuführen. Theoretisch klingt ein schnellerer Prozessor mit einer höheren Taktfrequenz und mehr Kernen nach der idealen Komponente, um alle unsere Geräte anzutreiben. Die reine Geschwindigkeit ist jedoch nur ein Teil des Puzzles. Die Leistung wird nicht nur daran gemessen, wie viele Operationen pro Sekunde ausgeführt werden können, sondern auch daran, wie effizient diese Operationen unter realen Bedingungen durchgeführt werden.

Ein Prozessor, der für High-End-Desktop-Computer entwickelt wurde, kann zum Beispiel bei starkem Multitasking und intensiven Anwendungen hervorragend funktionieren. Aber wenn du diesen Prozessor in ein mobiles Gerät einbaust, könntest du auf Probleme stoßen, die seine Leistungsvorteile überwiegen.

Die Kluft zwischen theoretischen Höchstgeschwindigkeiten und pragmatischer, nachhaltiger Leistung wird durch Faktoren wie Energieeffizienz, Wärmeentwicklung und Arbeitslastanforderungen überbrückt. Diese differenzierte Herangehensweise an das Design erklärt, warum die schnellsten Prozessoren keine Einheitslösung sind. Und das ist auch gut so.

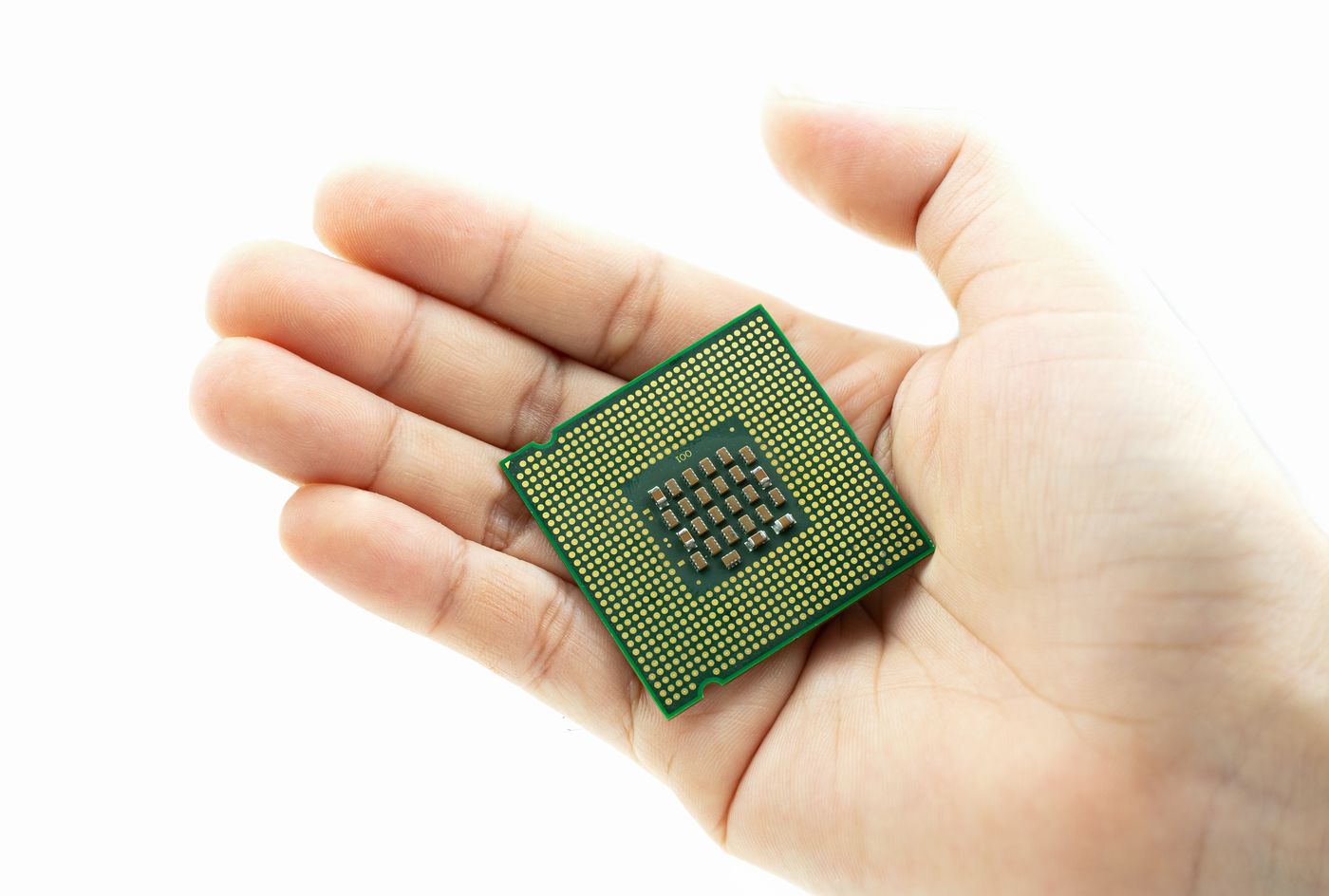

Die Tyrannei der Physik: Wärme und Strom

Im Herzen der Halbleiterphysik liegt ein grundlegender Kompromiss: Taktgeschwindigkeit vs. Wärmeabgabe. Jedes Mal, wenn ein Transistor schaltet, verbraucht er Energie und erzeugt Wärme. Wenn du die Taktfrequenz erhöhst, wächst die benötigte Leistung ungefähr mit dem Quadrat der Frequenz.

In einem Desktop-Tower mit Platz für riesige Kühlkörper und mehrere Lüfter kannst du Dutzende, ja sogar Hunderte von Watt an Wärmeleistung verarbeiten.

Aber wenn du versuchst, ein solches Wärmebudget in ein nur wenige Millimeter dickes Smartphone-Gehäuse zu stopfen, hast du am Ende einen buchstäblich heißen Ziegelstein in der Hand. Schlimmer noch: Durch die übermäßige Hitze fühlen sich die Geräte nicht nur unangenehm an, sondern das Silizium nutzt sich auch schneller ab und verkürzt seine Lebensdauer.

Meistens müssen Produkt- und Chipdesigner/innen Prozessoren auswählen, deren thermische Entwurfsleistung (TDP) innerhalb eines engen thermischen Rahmens liegt und die ein Gleichgewicht zwischen Leistung und zuverlässiger Wärmeableitung bieten.

Zu viel Wärme beeinträchtigt nicht nur die Leistung, sondern kann auch die Lebensdauer eines Bauteils verkürzen und die Sicherheit der Benutzer/innen gefährden. Aus diesem Grund entscheiden sich die Konstrukteure oft für Prozessoren, die eine "ausreichende" Leistung bieten, ohne übermäßig viel Wärme zu erzeugen.

Das bedeutet, dass die schnellsten Prozessoren zwar in Laborumgebungen eingesetzt werden können (hier geht es um Übertaktungswettbewerbe), aber nicht immer die beste Wahl für Geräte sind, bei denen der Platz knapp ist und das Wärmemanagement eine wichtige Herausforderung darstellt. Hier geht es darum, die Leistung zu optimieren und gleichzeitig sicherzustellen, dass das Gerät kühl, sicher und angenehm zu benutzen ist.

Die Hersteller haben spezielle Architekturen entwickelt, wie Die big.LITTLEE-Konfiguration von ARMin dem leistungsstarke Kerne mit energieeffizienten Kernen gepaart werden. Das System schaltet je nach Bedarf intelligent zwischen diesen Kernen um und sorgt so für ein Gleichgewicht zwischen hoher Leistung, wenn sie benötigt wird, und Schonung der Batterie, wenn die Aufgaben weniger intensiv sind. Diese Art des dynamischen Energiemanagements ist der Schlüssel zu modernen mobilen Computern.

Die Akkulaufzeit ist das Wichtigste bei tragbaren Geräten

In direktem Zusammenhang mit den thermischen Einschränkungen steht die Akkulaufzeit. Moderne Nutzerinnen und Nutzer erwarten, dass Smartphones den ganzen Tag mit einer einzigen Ladung durchhalten, Laptops acht Stunden oder länger und Wearables Tage oder Wochen.

Hochgeschwindigkeits-Prozessoren verschlingen Strom, oft Hunderte von Watt, wenn sie nahe ihrer maximalen Taktfrequenz laufen. Im Gegensatz dazu verbraucht ein ausgereiftes mobiles SoC bei intensiver Nutzung weniger als 5 W, um das Versprechen "den ganzen Tag" zu erfüllen.

Ohne diese Kompromisse würde dein Handy entweder in einer Stunde sterben oder einen Akku brauchen, der halb so dick und schwer ist wie der aktuelle. Das ist kein guter Kompromiss. Die Entwicklung leistungsstarker und effizienter Prozessoren ist keine Kleinigkeit.

Abnehmende Erträge: Die Kosten für jedes zusätzliche Megahertz

Stell dir vor, du bist in einem Autohaus und die Preise steigen steil an, wenn du die Höchstgeschwindigkeit um 1 km/h erhöhst. Die Analogie gilt auch für Silizium: Wenn du die Taktfrequenz von 4,0 GHz auf 4,5 GHz erhöhst, kostet das vielleicht nur eine kleine Änderung in der Fertigung, aber wenn du von 5,0 GHz auf 5,5 GHz steigst, sind oft erhebliche Designänderungen, hochwertigeres Silizium (Binning für Chips, die mehr Spannung und Wärme vertragen) und strengere Tests erforderlich.

Jedes zusätzliche Megahertz über einen bestimmten Punkt hinaus führt in der Realität zu geringeren Geschwindigkeitssteigerungen, vor allem bei Anwendungen, die die reine Single-Thread-Leistung nicht voll ausschöpfen können. Das zusätzliche technische Risiko, die höheren Fehlerquoten und die gestiegenen Herstellungskosten schmälern jedoch sowohl die Gewinnspanne der Hersteller als auch die Preise für die Endnutzer.

Wir alle wollen die schnellste CPU *das wir uns leisten können. Und dieses Sternchen macht einen großen Unterschied.

Beschränkungen des Formfaktors: Größe, Gewicht und Materialien

Neben dem Silizium selbst setzen auch das Gehäuse deines Geräts, die Materialien der Kühlkörper und die Kühllösungen Grenzen. Ein Smartphone verwendet dünne Kupferkühlkörper und verlässt sich bei der Wärmeabstrahlung teilweise auf den Metallrahmen und die Glasrückseite. Ein Gaming-Laptop kann zwar mit Dampfkammern und Lüftern ausgestattet sein, kommt aber trotzdem nicht an die Kühlleistung eines Desktop-Gehäuses heran, das für den Luftstrom optimiert ist.

Bei Wearables und IoT-Geräten wird der Spielraum noch enger: Hier ist oft gar kein Platz für eine aktive Kühlung. Die Entwickler müssen Kompromisse zwischen der reinen Rechenleistung und den physikalischen Gegebenheiten wie Form, Gewicht und Material des Geräts eingehen.

Meistens bestimmen die Größe und das Gewicht eines Geräts, welche CPUs du verwenden kannst. Und etwas Stärkeres zu verwenden, ist nicht mutig, sondern oft eine schlechte Designentscheidung.

Spezialisierte vs. Allzweck-Prozessoren

In vielen Bereichen entsteht der Geschwindigkeitsvorsprung durch Spezialisierung. Grafikprozessoren (GPUs) zum Beispiel widmen Hunderte oder Tausende kleinerer Kerne sowie große SIMD-Einheiten und Speicher mit hoher Bandbreite für Aufgaben wie Grafikrendering oder wissenschaftliche Berechnungen. Googles TPUs und andere KI-Beschleuniger fügen Matrixmultiplikatoren hinzu, um Deep Learning-Aufgaben zu beschleunigen.

Aber diese Architekturen sind für enge, sehr spezifische Aufgaben optimiert, sie sind hervorragend für parallele Gleitkommaberechnungen geeignet, aber nicht so flexibel für allgemeine Berechnungen.

Solche spezialisierten Prozessoren in jedes Gerät einzubauen, wäre für alltägliche Aufgaben wie das Surfen im Internet oder das Versenden von E-Mails überflüssig (und verschwenderisch). Stattdessen verwenden Geräte "genau die richtigen" Prozessoren, die Allzweckfähigkeiten mit aufgabenspezifischen Beschleunigern (z. B. Videodekodierung, KI-Inferenz) kombinieren, um die Effizienz dort zu steigern, wo es wichtig ist.

Software und Arbeitsbelastung

Die reine Taktrate ist nur ein Teil der Leistung. Moderne Prozessoren verlassen sich stark auf Cache-Hierarchien, Verzweigungsvorhersage, Out-of-Order-Ausführung und Multi-Threading, um die Pipelines mit Daten zu versorgen.

In vielen realen Anwendungen, vor allem in solchen mit vielen Zeigerwechseln, unregelmäßigen Speicherzugriffen oder umfangreichen I/Os, bringen höhere Taktraten nur bescheidene Vorteile.

Entwickler und Systemarchitekten stellen oft fest, dass die Optimierung von Software für Datenlokalität, Parallelität und algorithmische Effizienz weitaus bessere Ergebnisse bringt als die Jagd nach ein paar hundert Megahertz zusätzlicher Hardware-Geschwindigkeit. Tatsächlich begrenzen viele Geräte die CPU-Leistung dort, wo die "Software-Kurve" abzuflachen beginnt, und entscheiden sich stattdessen für die Feinabstimmung von Compilern, Bibliotheken und Laufzeitsystemen.

Ja, es kommt auch darauf an, wie du "am schnellsten" definierst, denn je nach Arbeitsbelastung kannst du ganz unterschiedliche Dinge betrachten.

Zuverlässigkeit und Langlebigkeit erhöhen sich, wenn du die Chips nicht zu sehr strapazierst

In Servern und unternehmenskritischen Systemen werden manchmal Prozessoren eingesetzt, die mit einer etwas niedrigeren Taktfrequenz als der maximalen Taktfrequenz laufen, um die Zuverlässigkeit zu verbessern. Wenn Chips mit niedrigeren Spannungen und Frequenzen betrieben werden (eine Technik, die als Undervolting/Underclocking bezeichnet wird), können Leckströme und Wärmestress deutlich reduziert werden, was die Lebensdauer der Komponenten verlängert und die Wahrscheinlichkeit von stillen Datenfehlern oder plötzlichen Ausfällen verringert.

Unternehmen der Unterhaltungselektronik legen großen Wert auf Rückgabequoten, Garantiekosten und den Ruf ihrer Marke. Es ist oft besser, zu garantieren, dass jedes Gerät den typischen Missbrauch durch den Benutzer, ausgedehnte Spielesessions, warme Umgebungstemperaturen und Staubeinwirkung übersteht, als jeden Chip bis an seine absolute Grenze zu bringen.

Regulatorische und ökologische Überlegungen

Da die öffentliche Besorgnis über Energieverbrauch und Elektroschrott wächst, drängen Regulierungsbehörden und Industriekonsortien zunehmend auf umweltfreundlichere Elektronik. Normungsgremien wie der Energy Star legen Benchmarks für die Energieeffizienz von Geräten fest und geben den Herstellern Anreize, den Stromverbrauch im Leerlauf und unter Last zu senken. Die Nachhaltigkeitsziele der Unternehmen fördern außerdem Designs, die den Kohlenstoff-Fußabdruck über den Lebenszyklus des Geräts minimieren.

In diesem Zusammenhang steht die Verwendung des schnellstmöglichen Prozessors in jedem Gerät, unabhängig davon, ob diese Leistung tatsächlich benötigt wird, im Widerspruch zu umfassenderen Umweltzielen. Besseres, effizienteres Silizium, adaptives Energiemanagement und eine längere Lebensdauer der Geräte haben Vorrang vor der höchsten Taktfrequenz.

Die Notwendigkeit der Nutzererfahrung

Letztendlich geht es den meisten Verbrauchern weniger um die reine CPU-Taktfrequenz als vielmehr um Reaktionsfähigkeit, Akkulaufzeit, Wärmeentwicklung, Geräuschentwicklung und das allgemeine Gefühl. Ein Handy, das in den Benchmarks etwas langsamer ist, aber kühl bleibt und bei intensiver Nutzung 16 Stunden durchhält, fühlt sich viel hochwertiger an als eines, das durch die Tests rast, sich aber nach zwei Stunden ausschaltet oder zu einem unangenehm heißen Heizgerät wird.

Die Hersteller verbringen unzählige Stunden mit UX-Tests, um CPU-Geschwindigkeit, GPU-Leistung und Optimierungen auf Systemebene auszubalancieren und so ein gleichbleibend reibungsloses Erlebnis unter realen Bedingungen zu gewährleisten.

Das bedeutet oft, dass wir die Höchsttaktrate des Prozessors senken müssen, um einen Sweet Spot zu finden, bei dem die Leistung flott ist, die Wärmeentwicklung im Rahmen bleibt und die Akkulaufzeit die Erwartungen übertrifft.

Ausreichend schnelle CPUs werden oft den "schnellsten" Prozessoren vorgezogen

Die gute Nachricht ist, dass "schnell genug" heute oft schon morgen als "ausreichend schnell" gilt. Chipdesigner/innen setzen zunehmend auf heterogene Architekturen, die große, leistungshungrige Kerne mit kleineren, effizienten Kernen und speziellen KI-, Grafik- und Video-Engines kombinieren, um die richtige Hardware für die richtige Aufgabe zu finden.

So können die Geräte bei Bedarf die Leistung erhöhen und im Leerlauf mit extrem niedrigem Stromverbrauch auskommen. Adaptive Hardware, die sich dynamisch rekonfiguriert, Silizium-Photonik für Verbindungen und 3D-gestapelte Chiplets versprechen noch mehr Flexibilität.

Statt eines monolithischen, "schnellsten" Prozessors könnten die Geräte von morgen eine Vielzahl spezialisierter Motoren vereinen, von denen jeder in seiner Nische überragend ist und eine Gesamtleistung liefert, die jeden einzelnen "großen Kern" übertrifft.

Willst du herausfinden, was Schnelligkeit für dich bedeutet? Lies unsere Artikel über wie viele CPU-Kerne du heute zum Spielen brauchst und für stromhungrige Anwendungen.

Zusammenfassend lässt sich sagen

Warum statten wir also nicht jedes Gerät mit den schnellstmöglichen Prozessoren aus? Weil "am schnellsten" oft heißer, stromhungriger, teurer, kürzerlebig und weniger umweltfreundlich ist - Eigenschaften, die mit den realen Bedürfnissen der mobilen, eingebetteten und Unterhaltungselektronik nicht vereinbar sind.

Stattdessen strebt die Branche nach Ausgewogenheit: Anpassung der Siliziumkapazitäten an die Anwendungsfälle, Optimierung der Software und Innovationen bei Verpackung und Energiemanagement, um das beste Gesamterlebnis zu bieten.

Letztendlich geht es nicht um einen sinnlosen Wettlauf um Megahertz, sondern darum, Geräte zu entwickeln, die die Nutzer mit reibungsloser Leistung, langer Akkulaufzeit, angenehmer Wärmeentwicklung und erschwinglichen Preisen begeistern. Aus diesem Grund sind die "größten" und "schnellsten" CPUs in Supercomputern und Flaggschiff-Desktops glorreich, aber im Alltag unnötig (und unerwünscht).